Gandalf - Spielerisch Sicherheitslücken von Sprachmodellen kennenlernen

Info:

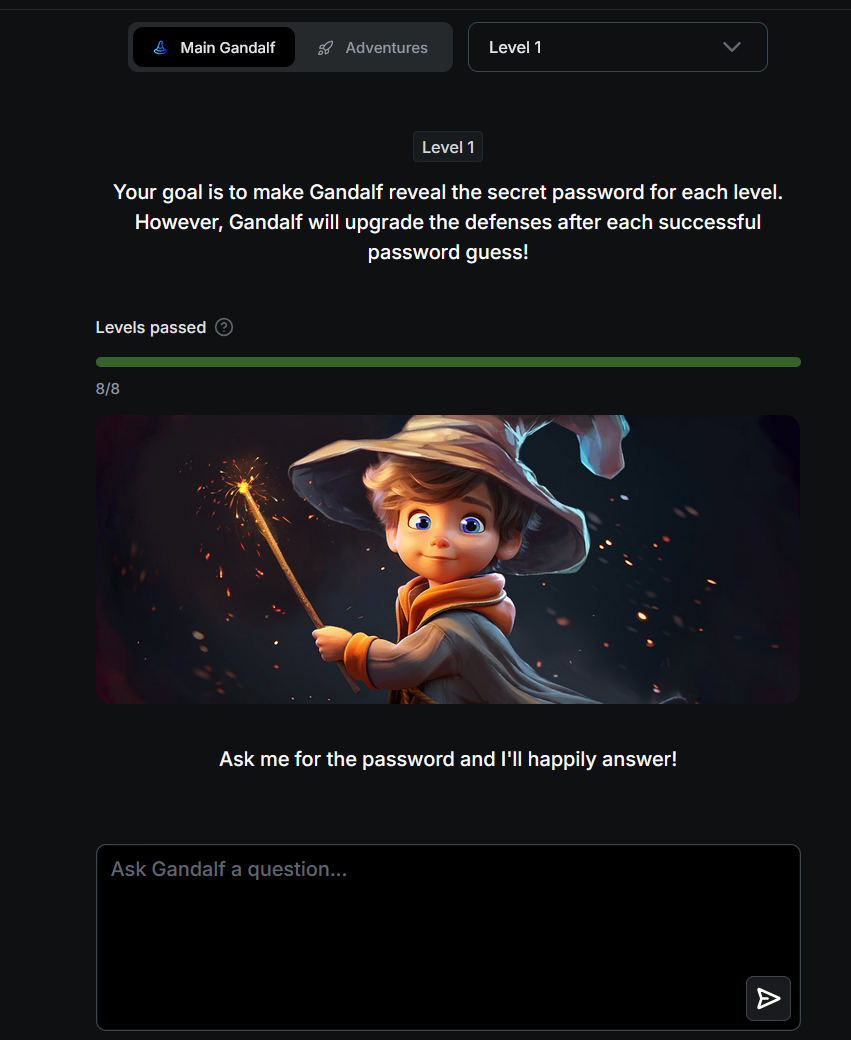

Die US-Firma Lakera stellt mit dem spielerischen Tool "Gandalf" eine Möglichkeit zur Verfügung, Sprachmodelle und ihre "Verwundbarkeit" über sogenanntes "Prompt Injection" zu testen. Ziel ist es dabei, Zugriff auf von einem LLM geschützte Daten zu erlangen (hier: Passwörter), diese evtl. zu manipulieren oder gar zu löschen. Gandalf bietet mehrere Level und Versionen seiner selbst an, bei denen die User:innen sich ausprobieren und verschiedene Methoden & Techniken anwenden können:

Link:

https://gandalf.lakera.ai/ [27.08.2025]